个人动态

分享日常生活的点滴

@Leopard青阳: 截至2026年1月,狼王格林的最新消息如下:

生存状态: 格林出生于2010年,截至2026年已16岁,属于狼的暮年阶段。2024年9月,探险者在若尔盖草原偶遇格林并投喂牛肉,证实其仍在原栖息地活动。2025年的记录显示,格林已出现毛发灰白、行动迟缓等衰老迹象,但仍具备基本生存能力 。

情感联系: 格林与“狼妈”李微漪的情感联系仍在延续。2025年,格林曾叼着一条红色丝巾(七年前李微漪为其唯一存活的孩子包扎伤口时使用的腰带),放在摄像头下后离开,以此表达对“妈妈”的思念与牵挂 。

李微漪每年都会去那个小木屋里待一段时间,格林每年都会发现,每天都会派狼给妈妈送肉,但是再也没有与妈妈相见,他已经成为狼王了,李微漪知道在寒冷最缺食物的冬天他们自己都不够吃,怕自己再呆下去狼群就很难度过这个冬天,于是就提前走了,他很爱妈妈,但是他再也没有与她相见,因为妈妈是人类,它已是狼王,要保护好它的狼群。李薇漪在给格林的孩子做的狼形墓碑下放了几颗大白兔奶糖,后来发现只剩下了包装纸。她知道那是格林吃的。因为格林从小在人类身边长大,他是一个会剥糖纸的狼。

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

pip config set install.trusted-host mirrors.aliyun.com

huggingface模型下载的最快速方法:

展开代码apt update && apt install -y aria2 wget https://hf-mirror.com/hfd/hfd.sh chmod a+x hfd.sh export HF_ENDPOINT=https://hf-mirror.com # 下载模型 ./hfd.sh mPLUG/GUI-Owl-32B # 下载数据 ./hfd.sh nlphuji/flickr30k --dataset --local-dir /mnt/data/datasets/huggingceface_data/

Dwarkesh Patel对AK的采访: https://www.dwarkesh.com/p/andrej-karpathy

主要观点

AGI 时间线 Karpathy 认为 AGI 的实现需要大约十年时间,而非一年。当前的 AI 助手虽然令人印象深刻,但缺乏多模态能力、持续学习和计算机使用能力。要让 AI 像员工或实习生一样工作,还需要解决诸多认知缺陷。

强化学习的局限 Karpathy 认为强化学习"很糟糕",但其他方法更差。RL 的问题在于它基于最终奖励对整个轨迹进行加权,就像"通过吸管吸取监督信号"——即使过程中有错误步骤,只要最终答案正确就会被正向加权。人类学习方式更复杂,会反思哪些步骤做得好或不好。

模型崩溃问题 LLM 生成的数据分布是"崩溃的"——缺乏多样性和熵。例如让 ChatGPT 讲笑话,它只会讲几个固定的笑话。如果持续在自己生成的合成数据上训练,模型会进一步崩溃。人类在一生中也会经历类似的"崩溃",思维变得越来越固化。

认知核心概念 Karpathy 提出"认知核心"概念——剥离知识但保留智能算法的系统。他认为 LLM 记忆了太多内容,这实际上分散了它们的注意力。理想的模型应该记忆更少,专注于通用的思维算法。他预测未来认知核心可能只需要 10 亿参数。

自动驾驶经验 从演示到产品存在巨大鸿沟。自动驾驶就是典型案例——1980 年代就有演示,2014 年 Waymo 已经能完美驾驶,但产品化仍需很长时间。这是一个"九的进军"——从 90% 准确到 99% 再到 99.9%,每增加一个九都需要相同的工作量。

AGI 对经济的影响 Karpathy 认为 AGI 不会造成经济突变,而会融入过去 250 年 2% 的 GDP 增长曲线中。他将 AI 视为计算的延续,就像编译器、搜索引擎等技术一样,是渐进式的自动化进程。即使是工业革命也是逐步扩散的,而非离散跳跃。

编码助手的现状 Karpathy 在构建 nanochat 时发现编码模型帮助有限。它们擅长样板代码和常见模式,但在独特的、智力密集的代码上表现不佳。自动补全仍是他的首选工具,而非完全的 AI 代码生成。

人类与 AI 学习的差异 Karpathy 指出人类不太依赖强化学习,更多是大脑的成熟过程。进化通过 DNA 编码了大量先天能力(如斑马出生几分钟就能奔跑),这不是强化学习,而是内置的硬件。LLM 是通过模仿互联网数据创建的"幽灵般的实体",与动物智能的演化路径完全不同。

这次访谈深入探讨了当前 AI 的技术瓶颈、未来发展路径,以及 AGI 对社会经济的潜在影响,提供了来自一线研究者的独特视角。

啦啦啦啦~ 以后的某个时刻,我能想起我午后在啦啦啦吗?

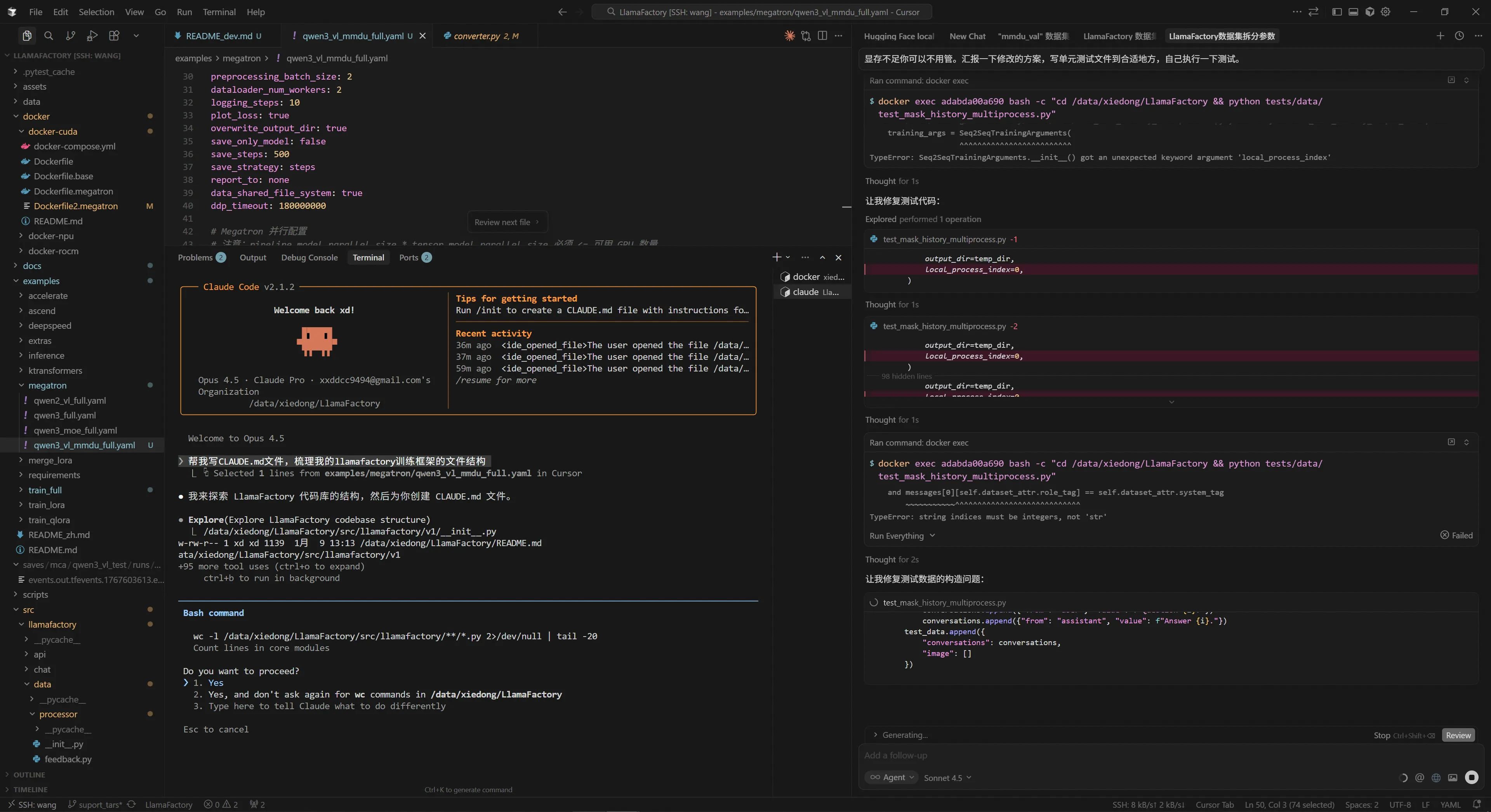

被模型做局了,解决复杂代码问题,除了claude-4-sonnet模型,其他模型真的是一直在原地打转!

win11是真的恶心人,来不来就一点小bug。

cursor只能开tun了,trae倒是可以用,还便宜一些。

其实我也是第一次见到,有的算法工程项目居然是屎山代码。